商機詳情 -

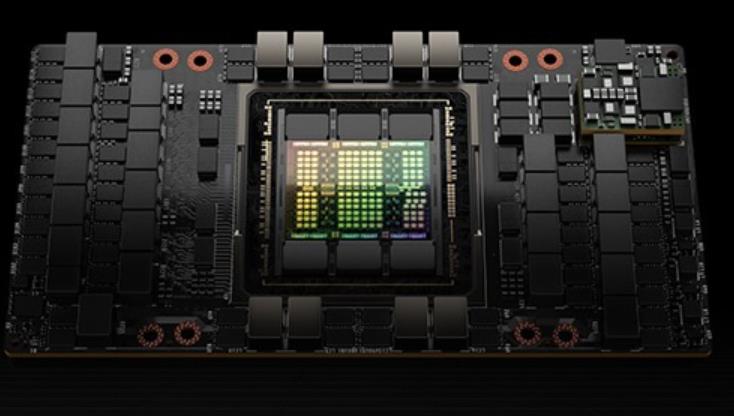

北京模組H100GPU

H100 GPU 還集成了多種先進的安全和管理功能。例如,它支持 NVIDIA 的 GPU Direct 技術,能夠實現 GPU 之間的直接通信,減少了 CPU 參與的數據傳輸延遲,提升了數據傳輸效率。此外,H100 GPU 還支持多種虛擬化技術,如 NVIDIA vGPU,能夠在虛擬化環境中提供高性能的圖形和計算服務。其多樣化的管理和安全功能,使得 H100 GPU 在企業級數據中心和云計算平臺中具備了更高的適用性和管理便捷性。在能效方面,H100 GPU 也表現優異。其功耗設計為 400W,但在實際使用中,通過優化負載分配和動態電壓頻率調節(DVFS)技術,可以有效降低功耗,提高能效比。對于需要長時間運行的大規模計算任務,H100 GPU 的高能效設計不僅可以降低運營成本,還減少了對環境的影響。其先進的功耗管理技術確保了在提供高性能計算的同時,依然能夠保持較低的能源消耗。H100 GPU 降價促銷,機會難得。北京模組H100GPU

英偉達可以純粹提高價格以找到清算價格,并且在某種程度上正在這樣做。但重要的是要知道,終H100的分配取決于Nvidia更喜歡將分配分配給誰。供應H100顯卡#造成瓶頸的原因-供應生產方面的瓶頸是什么?哪些組件?誰生產它們?誰制造了H100?#臺積電。英偉達可以使用其他芯片廠進行H100生產嗎?#不是真的,至少現在還沒有。他們過去曾與三星合作過。但在H100和其他5nmGPU上,他們只使用臺積電。這意味著三星還不能滿足他們對前列GPU的需求。他們將來可能會與英特爾合作,并再次與三星合作,但這些都不會在短期內以有助于H100供應緊縮的方式發生。不同的臺積電節點如何關聯?#臺積電5nm系列:N5264N要么適合作為N5的增強版本,要么低于N5PN5P4N要么適合作為N5P的增強版本,要么低于N5作為N5的增強版本N4N4PH100是在哪個臺積電節點上制造的?#臺積電4N。這是Nvidia的一個特殊節點,它屬于5nm系列,并且是增強的5nm,而不是真正的4nm。還有誰使用該節點?#是蘋果,但他們主要轉向N3,并保留了大部分N3容量。高通和AMD是N5家族的其他大客戶。A100使用哪個臺積電節點?#N727晶圓廠產能通常提前多久預留?#不確定,雖然可能是12+個月。技嘉H100GPU一臺多少錢H100 GPU 降價特惠,先到先得。

H100 GPU 在云計算中的應用也非常多。它的高并行處理能力和大帶寬內存使云計算平臺能夠高效地處理大量并發任務,提升整體服務質量。H100 GPU 的靈活性和易管理性使其能夠輕松集成到各種云計算架構中,滿足不同客戶的需求。無論是公共云、私有云還是混合云環境,H100 GPU 都能提供強大的計算支持,推動云計算技術的發展和普及。其高能效設計不僅提升了性能,還為企業節省了大量的能源成本。通過在云計算平臺中的應用,H100 GPU 不僅提高了計算資源的利用率,還實現了資源的靈活調配和高效管理,為企業和個人用戶提供了更加便捷和高效的計算服務。

H100GPU層次結構和異步性改進關鍵數據局部性:將程序數據盡可能的靠近執行單元異步執行:尋找的任務與內存傳輸和其他事物重疊。目標是使GPU中的所有單元都能得到充分利用。線程塊集群(ThreadBlockClusters)提出背景:線程塊包含多個線程并發運行在單個SM上,這些線程可以使用SM的共享內存與快速屏障同步并交換數據。然而,隨著GPU規模超過100個SM,計算程序變得更加復雜,線程塊作為編程模型中***表示的局部性單元不足以大化執行效率。Cluster是一組線程塊,它們被保證并發調度到一組SM上,其目標是使跨多個SM的線程能夠有效地協作。GPC:GPU處理集群,是硬件層次結構中一組物理上總是緊密相連的子模塊。H100中的集群中的線程在一個GPC內跨SM同時運行。集群有硬件加速障礙和新的訪存協作能力,在一個GPC中SM的一個SM-to-SM網絡提供集群中線程之間快速的數據共享。分布式共享內存(DSMEM)通過集群,所有線程都可以直接訪問其他SM的共享內存,并進行加載(load)、存儲(store)和原子(atomic)操作。SM-to-SM網絡保證了對遠程DSMEM的快速、低延遲訪問。在CUDA層面。集群中所有線程塊的所有DSMEM段被映射到每個線程的通用地址空間中。近期 H100 GPU 的價格波動引起了關注。

以提供SHARP在網絡中的縮減和任意對GPU之間900GB/s的完整NVLink帶寬。H100SXM5GPU還被用于功能強大的新型DGXH100服務器和DGXSuperPOD系統中。H100PCIeGen5GPU以有350W的熱設計功耗(ThermalDesignPower,TDP),提供了H100SXM5GPU的全部能力該配置可選擇性地使用NVLink橋以600GB/s的帶寬連接多達兩個GPU,接近PCIeGen5的5倍。H100PCIe非常適合主流加速服務器(使用標準的架構,提供更低服務器功耗),為同時擴展到1或2個GPU的應用提供了很好的性能,包括AIInference和一些HPC應用。在10個前列數據分析、AI和HPC應用程序的數據集中,單個H100PCIeGPU**地提供了H100SXM5GPU的65%的交付性能,同時消耗了50%的功耗。DGXH100andDGXSuperPODNVIDIADGXH100是一個通用的高性能人工智能系統,用于訓練、推理和分析。配置了Bluefield-3,NDRInfiniBand和第二代MIG技術單個DGXH100系統提供了16petaFLOPS(千萬億次浮點運算)(FP16稀疏AI計算性能)。通過將多個DGXH100系統連接組成集群(稱為DGXPODs或DGXSuperPODs)。DGXSuperPOD從32個DGXH100系統開始,被稱為"可擴展單元"集成了256個H100GPU,這些GPU通過基于第三代NVSwitch技術的新的二級NVLink交換機連接。H100 GPU 支持多 GPU 配置。HPEH100GPU一臺多少錢

H100 GPU 提供高效的技術支持。北京模組H100GPU

它可能每年產生$500mm++的經常性收入。ChatGPT運行在GPT-4和API上。GPT-4和API需要GPU才能運行。很多。OpenAI希望為ChatGPT及其API發布更多功能,但他們不能,因為他們無法訪問足夠的GPU。他們通過Microsoft/Azure購買了很多NvidiaGPU。具體來說,他們想要的GPU是NvidiaH100GPU。為了制造H100SXMGPU,Nvidia使用臺積電進行制造,并使用臺積電的CoWoS封裝技術,并使用主要來自SK海力士的HBM3。OpenAI并不是***一家想要GPU的公司(但他們是產品市場契合度強的公司)。其他公司也希望訓練大型AI模型。其中一些用例是有意義的,但有些用例更多的是驅動的,不太可能使產品與市場契合。這推高了需求。此外,一些公司擔心將來無法訪問GPU,因此即使他們還不需要它們,他們現在也會下訂單。因此,“對供應短缺的預期會造成更多的供應短缺”正在發生。GPU需求的另一個主要貢獻者來自想要創建新的LLM的公司。以下是關于想要構建新LLM的公司對GPU需求的故事:公司高管或創始人知道人工智能領域有很大的機會。也許他們是一家想要在自己的數據上訓練LLM并在外部使用它或出售訪問權限的企業,或者他們是一家想要構建LLM并出售訪問權限的初創公司。他們知道他們需要GPU來訓練大型模型。北京模組H100GPU