商機詳情 -

廣東80GH100GPU

因此線程可以自由地執行其他**的工作。②終線程需要其他所有線程產生的數據。在這一點上,他們做一個"等待",直到每個線程都有"抵達"的信號。-***是允許提前到達的線程在等待時執行**的工作。-等待的線程會在共享內存中的屏障對象上自轉(spin)(我理解的就是這些等待的線程在等待的時候無法執行其他工作)也是一個分裂的屏障,但不對到達的線程計數,同時也對事務進行計數。為寫入共享內存引入一個新的命令,同時傳遞要寫入的數據和事務計數。事務計數本質上是對字節計數異步事務屏障會在W**t命令處阻塞線程,直到所有生產者線程都執行了一個Arrive,所有事務計數之和達到期望值。異步事務屏障是異步內存拷貝或數據交換的一種強有力的新原語。集群可以進行線程塊到線程塊通信,進行隱含同步的數據交換,集群能力建立在異步事務屏障之上。H100HBM和L2cache內存架構HBM存儲器由內存堆棧組成,位于與GPU相同的物理封裝上,與傳統的GDDR5/6內存相比,提供了可觀的功耗和面積節省,允許更多的GPU被安裝在系統中。H100 GPU 適用于智能制造領域。廣東80GH100GPU

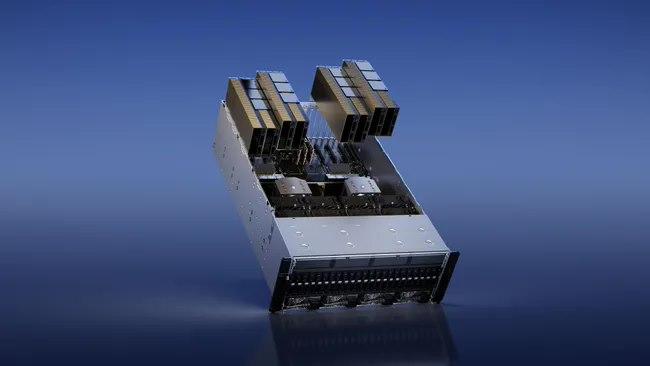

在大預言模型中達到9倍的AI訓練速度和30倍的AI推理速度。HBM3內存子系統提供近2倍的帶寬提升。H100SXM5GPU是世界上款采用HBM3內存的GPU,其內存帶寬達到3TB/sec。50MB的L2Cache架構緩存了大量的模型和數據以進行重復訪問,減少了對HBM3的重復訪問次數。第二代多實例GPU(Multi-InstanceGPU,MIG)技術為每個GPU實例提供約3倍的計算能量和近2倍的內存帶寬。次支持機密計算,在7個GPU實例的虛擬化環境中支持多租戶、多用戶配置。(MIG的技術原理:作業可同時在不同的實例上運行,每個實例都有的計算、顯存和顯存帶寬資源,從而實現可預測的性能,同時符合服務質量(QoS)并盡可能提升GPU利用率。)新的機密計算支持保護用戶數據,防御硬件和軟件攻擊,在虛擬化和MIG環境中更好的隔離和保護虛擬機。H100實現了世界上個國產的機密計算GPU,并以全PCIe線速擴展了CPU的可信執行環境。第四代NVIDIANVLink在全歸約操作上提供了3倍的帶寬提升,在7倍PCIeGen5帶寬下,為多GPUIO提供了900GB/sec的總帶寬。比上一代NVLink增加了50%的總帶寬。第三代NVSwitch技術包括駐留在節點內部和外部的交換機,用于連接服務器、集群和數據中心環境中的多個GPU。廣東80GH100GPUH100 GPU 特價銷售,趕快搶購。

我們將定期舉辦技術交流會和培訓,幫助客戶更好地了解和使用 H100 GPU 產品。通過與客戶的面對面交流,ITMALL.sale 不僅能夠分享新的技術和產品信息,還能夠深入了解客戶的需求和挑戰。ITMALL.sale 的技術前輩會在交流會上詳細講解 H100 GPU 的使用方法和最佳實踐,解答客戶的技術問題,并提供實用的建議和解決方案,幫助客戶充分發揮 H100 GPU 的性能,提升業務效率。ITMALL.sale 的技術交流會不僅是客戶學習和提升的機會,也是客戶與行業前輩交流和合作的平臺,促進技術進步和創新發展。

硬件方面的TPU,Inferentia,LLMASIC和其他產品,以及軟件方面的Mojo,Triton和其他產品,以及使用AMD硬件和軟件的樣子。我正在探索一切,盡管專注于***可用的東西。如果您是自由職業者,并希望幫助Llama2在不同的硬件上運行,請給我發電子郵件。到目前為止,我們已經在AMD,Gaudi上運行了TPU和Inferentia,并且來自AWSSilicon,R**n,Groq,Cerebras和其他公司的人員提供了幫助。確認#本文包含大量專有和以前未發布的信息。當您看到人們對GPU生產能力感到疑惑時,請向他們指出這篇文章的方向。感謝私有GPU云公司的少數高管和創始人,一些AI創始人,ML工程師,深度學習研究員,其他一些行業和一些非行業讀者,他們提供了有用的評論。感謝哈米德的插圖。A100\H100基本上越來越少,A800目前也在位H800讓路,如果確實需要A100\A800\H100\H800GPU,建議就不用挑剔了,HGX和PCIE版對大部分使用者來說區別不是很大,有貨就可以下手了。無論如何,選擇正規品牌廠商合作,在目前供需失衡不正常的市場情況下,市面大部分商家是無法供應的,甚至提供不屬實的信息。H100 GPU 優惠直降,數量有限。

它可能每年產生$500mm++的經常性收入。ChatGPT運行在GPT-4和API上。GPT-4和API需要GPU才能運行。很多。OpenAI希望為ChatGPT及其API發布更多功能,但他們不能,因為他們無法訪問足夠的GPU。他們通過Microsoft/Azure購買了很多NvidiaGPU。具體來說,他們想要的GPU是NvidiaH100GPU。為了制造H100SXMGPU,Nvidia使用臺積電進行制造,并使用臺積電的CoWoS封裝技術,并使用主要來自SK海力士的HBM3。OpenAI并不是***一家想要GPU的公司(但他們是產品市場契合度強的公司)。其他公司也希望訓練大型AI模型。其中一些用例是有意義的,但有些用例更多的是驅動的,不太可能使產品與市場契合。這推高了需求。此外,一些公司擔心將來無法訪問GPU,因此即使他們還不需要它們,他們現在也會下訂單。因此,“對供應短缺的預期會造成更多的供應短缺”正在發生。GPU需求的另一個主要貢獻者來自想要創建新的LLM的公司。以下是關于想要構建新LLM的公司對GPU需求的故事:公司高管或創始人知道人工智能領域有很大的機會。也許他們是一家想要在自己的數據上訓練LLM并在外部使用它或出售訪問權限的企業,或者他們是一家想要構建LLM并出售訪問權限的初創公司。他們知道他們需要GPU來訓練大型模型。H100 GPU 價格直降,搶購從速。上海80GH100GPU

H100 GPU 支持多 GPU 配置。廣東80GH100GPU

使用TSMC4nm工藝定制800億個晶體管,814mm2芯片面積。NVIDIAGraceHopperSuperchipCPU+GPU架構NVIDIAGraceCPU:利用ARM架構的靈活性,創建了從底層設計的CPU和服務器架構,用于加速計算。H100:通過NVIDIA的超高速片間互連與Grace配對,能提供900GB/s的帶寬,比PCIeGen5快了7倍目錄H100GPU主要特征基于H100的系統和板卡H100張量架構FP8數據格式用于加速動態規劃(“DynamicProgramming”)的DPX指令L1數據cache和共享內存結合H100GPU層次結構和異步性改進線程塊集群(ThreadBlockClusters)分布式共享內存(DSMEM)異步執行H100HBM和L2cache內存架構H100HBM3和HBM2eDRAM子系統H100L2cache內存子系統RAS特征第二代安全MIGTransformer引擎第四代NVLink和NVLink網絡第三代NVSwitch新的NVLink交換系統PCIeGen5安全性增強和保密計算H100video/IO特征H100GPU主要特征新的流式多處理器(StreamingMultiprocessor,SM)第四代張量:片間通信速率提高了6倍(包括單個SM加速、額外的SM數量、更高的時鐘);在等效數據類型上提供了2倍的矩陣乘加。MatrixMultiply-Accumulate,MMA)計算速率,相比于之前的16位浮點運算,使用新的FP8數據類型使速率提高了4倍。廣東80GH100GPU