商機詳情 -

IranH100GPU list price

使用TSMC4nm工藝定制800億個晶體管,814mm2芯片面積。NVIDIAGraceHopperSuperchipCPU+GPU架構NVIDIAGraceCPU:利用ARM架構的靈活性,創建了從底層設計的CPU和服務器架構,用于加速計算。H100:通過NVIDIA的超高速片間互連與Grace配對,能提供900GB/s的帶寬,比PCIeGen5快了7倍目錄H100GPU主要特征基于H100的系統和板卡H100張量架構FP8數據格式用于加速動態規劃(“DynamicProgramming”)的DPX指令L1數據cache和共享內存結合H100GPU層次結構和異步性改進線程塊集群(ThreadBlockClusters)分布式共享內存(DSMEM)異步執行H100HBM和L2cache內存架構H100HBM3和HBM2eDRAM子系統H100L2cache內存子系統RAS特征第二代安全MIGTransformer引擎第四代NVLink和NVLink網絡第三代NVSwitch新的NVLink交換系統PCIeGen5安全性增強和保密計算H100video/IO特征H100GPU主要特征新的流式多處理器(StreamingMultiprocessor,SM)第四代張量:片間通信速率提高了6倍(包括單個SM加速、額外的SM數量、更高的時鐘);在等效數據類型上提供了2倍的矩陣乘加。MatrixMultiply-Accumulate,MMA)計算速率,相比于之前的16位浮點運算,使用新的FP8數據類型使速率提高了4倍。H100 GPU 降價特惠,先到先得。IranH100GPU list price

ITMALL.sale 擁有豐富的行業經驗和專業的技術團隊,能夠為客戶提供專業的 H100 GPU 咨詢和技術支持。ITMALL.sale 深知每個客戶的需求都是獨特的,因此在銷售過程中注重與客戶的溝通,了解其具體需求,提供量身定制的解決方案。ITMALL.sale 的技術團隊能夠幫助客戶快速部署和優化 H100 GPU 系統,確保其能夠充分發揮 H100 GPU 的強大性能,為客戶的業務發展提供強有力的支持。

ITMALL.sale 擁有完善的供應鏈和物流體系,確保客戶能夠快速、便捷地獲得 H100 GPU 產品。ITMALL.sale 與多家物流公司合作,能夠提供靈活的配送服務,滿足不同客戶的配送需求。無論是大批量采購還是小批量訂購,ITMALL.sale 都能夠確保產品及時送達。ITMALL.sale 的倉儲和物流團隊經過專業培訓,能夠高效、安全地處理每一筆訂單,確保產品在運輸過程中完好無損地送到客戶手中。 英偉達H100GPU how muchH100 GPU 的帶寬高達 1.6 TB/s。

H100 GPU 通過其強大的計算能力和高效的數據傳輸能力,為分布式計算提供了強有力的支持。其并行處理能力和大帶寬內存可以高效處理和傳輸大量數據,提升整體計算效率。H100 GPU 的穩定性和可靠性為長時間高負荷運行的分布式計算任務提供了堅實保障。此外,H100 GPU 的靈活擴展能力使其能夠輕松集成到各種分布式計算架構中,滿足不同應用需求,成為分布式計算領域的重要工具。H100 GPU 的市場價格在過去一段時間內經歷了明顯的波動。隨著高性能計算需求的增加,H100 GPU 在人工智能、深度學習和大數據分析等領域的應用越來越多,市場需求不斷攀升,推動了價格的上漲。同時,全球芯片短缺和物流成本的上升也對 H100 GPU 的價格產生了不利影響。盡管如此,隨著供應鏈的逐步恢復和市場需求的平衡,H100 GPU 的價格有望在未來逐漸回落。對于企業和研究機構來說,了解價格動態并選擇合適的采購時機至關重要。

稀疏性特征利用了深度學習網絡中的細粒度結構化稀疏性,使標準張量性能翻倍。新的DPX指令加速了動態規劃算法達到7倍。IEEEFP64和FP32的芯片到芯片處理速率提高了3倍(因為單個SM逐時鐘(clock-for-clock)性能提高了2倍;額外的SM數量;更快的時鐘)新的線程塊集群特性(ThreadBlockClusterfeature)允許在更大的粒度上對局部性進行編程控制(相比于單個SM上的單線程塊)。這擴展了CUDA編程模型,在編程層次結構中增加了另一個層次,包括線程(Thread)、線程塊(ThreadBlocks)、線程塊集群(ThreadBlockCluster)和網格(Grids)。集群允許多個線程塊在多個SM上并發運行,以同步和協作的獲取數據和交換數據。新的異步執行特征包括一個新的張量存儲加速(TensorMemoryAccelerator,TMA)單元,它可以在全局內存和共享內存之間非常有效的傳輸大塊數據。TMA還支持集群中線程塊之間的異步拷貝。還有一種新的異步事務屏障,用于進行原子數據的移動和同步。新的Transformer引擎采用專門設計的軟件和自定義Hopper張量技術相結合的方式。Transformer引擎在FP8和16位計算之間進行智能管理和動態選擇,在每一層中自動處理FP8和16位之間的重新選擇和縮放。H100 GPU 的單精度浮點計算能力為 19.5 TFLOPS。

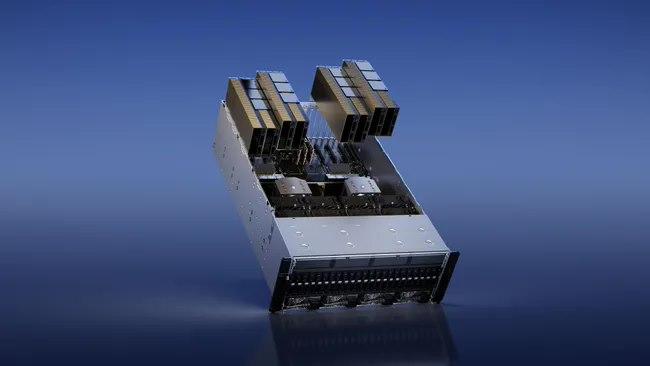

用于訓練、推理和分析。配置了Bluefield-3,NDRInfiniBand和第二代MIG技術單個DGXH100系統提供了16petaFLOPS(千萬億次浮點運算)(FP16稀疏AI計算性能)。通過將多個DGXH100系統連接組成集群(稱為DGXPODs或DGXSuperPODs),可以很容易地擴大這種性能。DGXSuperPOD從32個DGXH100系統開始,被稱為"可擴展單元"集成了256個H100GPU,這些GPU通過基于第三代NVSwitch技術的新的二級NVLink交換機連接,提供了1exaFLOP的FP8稀疏AI計算性能。同時支持無線帶寬(InifiniBand,IB)和NVLINKSwitch網絡選項。HGXH100通過NVLink和NVSwitch提供的高速互連,HGXH100將多個H100結合起來,使其能創建世界上強大的可擴展服務器。HGXH100可作為服務器構建模塊,以集成底板的形式在4個或8個H100GPU配置中使用。H100CNXConvergedAcceleratorNVIDIAH100CNX將NVIDIAH100GPU的強大功能與NVIDIA?ConnectX-7SmartNIC的**組網能力相結合,可提供高達400Gb/s的帶寬包括NVIDIAASAP2(加速交換和分組處理)等創新功能,以及用于TLS/IPsec/MACsec加密/的在線硬件加速。這種獨特的架構為GPU驅動的I/O密集型工作負載提供了前所未有的性能,如在企業數據中心進行分布式AI訓練,或在邊緣進行5G信號處理等。H100 GPU 優惠促銷,馬上下單。AmericaH100GPU促銷

H100 GPU 具備高效的數據傳輸能力。IranH100GPU list price

它可能每年產生$500mm++的經常性收入。ChatGPT運行在GPT-4和API上。GPT-4和API需要GPU才能運行。很多。OpenAI希望為ChatGPT及其API發布更多功能,但他們不能,因為他們無法訪問足夠的GPU。他們通過Microsoft/Azure購買了很多NvidiaGPU。具體來說,他們想要的GPU是NvidiaH100GPU。為了制造H100SXMGPU,Nvidia使用臺積電進行制造,并使用臺積電的CoWoS封裝技術,并使用主要來自SK海力士的HBM3。OpenAI并不是***一家想要GPU的公司(但他們是產品市場契合度強的公司)。其他公司也希望訓練大型AI模型。其中一些用例是有意義的,但有些用例更多的是驅動的,不太可能使產品與市場契合。這推高了需求。此外,一些公司擔心將來無法訪問GPU,因此即使他們還不需要它們,他們現在也會下訂單。因此,“對供應短缺的預期會造成更多的供應短缺”正在發生。GPU需求的另一個主要貢獻者來自想要創建新的LLM的公司。以下是關于想要構建新LLM的公司對GPU需求的故事:公司高管或創始人知道人工智能領域有很大的機會。也許他們是一家想要在自己的數據上訓練LLM并在外部使用它或出售訪問權限的企業,或者他們是一家想要構建LLM并出售訪問權限的初創公司。他們知道他們需要GPU來訓練大型模型。IranH100GPU list price